如何优化并提高网站抓取频次

阅读 · 发布日期 2020-05-09 08:30 · admin关于“搜索引擎优化”,我的第一反应直接跳到SEO排名因素中,如正确的标签,相关的关键词,干净的站点地图,优秀的设计元素以及源源不断的高质量内容。最近看到的一篇文章让我意识到“抓取频次”的重要性。这让我想知道:抓取频次优化如何与SEO有什么关系?如何优化并提高网站抓取频次?网站建设★网站设计★网站制作★网页设计-599元全包;企业网络推广☆网站优化☆seo☆关键词排名☆百度快照-2200元全年展示;做网站优化排名-网站建设公司

什么是抓取频次?

搜索引擎使用网站爬虫蜘蛛来抓取网页,收集有关它们的信息,并将它们添加到索引中。这些蜘蛛还检测他们访问的页面上的链接,并尝试抓取这些新页面。

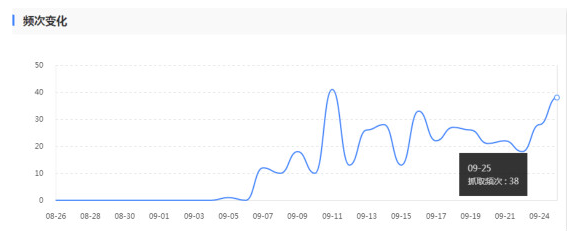

你可能熟悉的机器人Baiduspider,它可以发现新的网页并将其添加到百度索引。大多数SEO工具和其他网站服务也依赖于蜘蛛来收集信息。我们称之为“抓取频次”的是搜索引擎蜘蛛在指定时间段内抓取你网站的次数。因此,如果Baiduspider每天访问你的网站32次,我们可以说你的百度抓取频次约为960次每月。

你可以使用百度搜索资源平台工具来确定你网站的近似抓取频次。只需登录数据监控>抓取频次统计信息,即可查看每天抓取频次。

抓取频次优化与SEO相同吗?

虽然这两种类型的优化都旨在使你的页面更加醒目,并且可能会影响你的搜索页面排名结果,但SEO更强调用户体验,而蜘蛛优化则完全是对机器人的吸引力。

搜索引擎优化更侧重于优化用户查询的过程。Baiduspider优化专注于百度抓取工具访问你网站的方式。那么如何具体优化抓取频次呢?下面的一些建议希望可以帮助你尽可能地抓取你的网站。

如何优化你的抓取频次?

确保你的页面可以抓取

如果搜索引擎蜘蛛可以查找并关注你网站中的链接,则你的网页是可抓取的,因此你必须配置.htaccess和robots.txt,以便它们不会阻止你网站的关键网页。如果要阻止页面被收录索引,仅将“Robots.txt”设置为“Disallow”是不够的。根据百度的说法:“Robots.txt的Disallow不保证页面不会出现在结果中。”

如果外部信息(反向链接)继续将流量引导至你不允许的网页,百度可能会认为该网页仍然相关。在这种情况下,你需要使用noindex元标记或X-Robots-Tag HTTP标头手动阻止页面被收录索引。

•noindex元标记:将以下元标记放在页面的<head>部分,以防止大多数网页抓取工具为你的网页收录索引:

noindex“/>

•X-Robots-Tag:将以下内容放在HTTP标头响应中,告诉抓取工具不要索引页面:

X-Robots-Tag:noindex

如果你使用noindex元标记或X-Robots-Tag,就不要禁用robots.txt中的页面。必须先抓取该页面,然后才能看到并遵循该标记。

避免重定向链

你重定向到的每个网址都会浪费一些抓取频次。如果你的网站具有较多的重定向链,存在大量301和302重定向,那么蜘蛛可能会在到达目标网页之前丢失,这意味着该网页不会被收录索引。重定向的最佳做法是在你的网站上尽可能少地使用,并且不要连续超过两次。

修复死链

死链会极大的浪费搜索抓取频次,它们极大地阻碍了百度蜘蛛对你的网站进行索引和排名的能力。同时死链对于用户也是极大的影响体验,任何影响用户体验的因素都可能影响搜索结果排名。

尽量避免动态URL抓取

蜘蛛会将动态网址视为与相同的单独网页页面,这意味着你可能会不必要地浪费你的抓取频次。你可以到你的robots.txt屏蔽这些动态参数页面的抓取。

清理站点地图

为了让你的内容更有条理,更易于查找,XML站点地图可以帮助你的用户和蜘蛛机器人。尽量使你的站点地图保持最新,并清除可能损害你网站可用性的任何混乱,包括400类页面,不必要的重定向,非规范页面和阻止抓取的页面。

建立外部链接

蜘蛛访问次数与外部链接数量和质量密切相关。

保持内部链接完整性

内部链接建设在爬行率方面没有发挥重要作用,但这并不意味着你可以完全忽视它。维护良好的网站结构使你的内容可以被搜索机器人轻松发现,而不会浪费你的抓取频次。

良好的内部链接结构也可以改善用户体验,让一切变得更容易访问意味着访问者会更长时间逗留,这可能会提高你的搜索结果排名。

抓取频次是否重要?

提高可抓取性的最佳实践建议也会提高你的可搜索性。如果你想知道爬行预算优化是否对你的网站很重要,答案是肯定的,它可能会与你的SEO工作密切相关。

简而言之,当你让百度更容易发现并为你的网站收录索引时,你将享受更多抓取功能,这意味着你在发布新内容时可以更快地进行更新。你还将改善整体用户体验,从而提高可见性,最终实现更好的搜索结果页面排名。

- 上一篇:网站如何打造高质量内容

- 下一篇:关于标题标签的SEO提示和技巧